AI-1편은 ChatGPT에 대한 이야기라면 두번째 이야기는 Perplexity야.

AI 기술이 발전하면서 ChatGPT와 같은 대화형 AI가 많이 사용되고 있어.

하지만 이런 AI가 얼마나 정확하게 예측하는지 평가할 방법이 필요해. 바로 그 기준이 Perplexity야.

Perplexity는 모델이 얼마나 잘 예측하는지 측정하는 수치로, 우리가 사용하는 AI가 얼마나 똑똑한지 알 수 있는 중요한 지표야. 이번 글에서는 Perplexity가 무엇인지, 왜 중요한지 쉽게 설명할 거야.

아저씨 아줌마들은 아래 내용은 그냥 대충 이런게 있구나 하고 알면 되고 요약부분만 보고 이해하면 될꺼야!

1. Perplexity란 무엇인가?

Perplexity는 언어 모델의 예측 능력을 평가하는 지표로, 모델이 얼마나 "혼란스러워"하는지를 나타내는 숫자야. 쉽게 말해, 모델이 다음에 올 단어를 얼마나 잘 예측하는지를 측정하는 거지.

자, 예를 들어서, "오늘 날씨가"라는 문장이 있을 때, 모델이 다음에 올 단어로 "좋다"를 예측하는 게 얼마나 쉬운지, 아니면 어려운지를 나타내는 거야. 모델이 "오늘 날씨가"라는 부분에서 "좋다"를 예측하는 데 별로 혼란스러워하지 않았다면, Perplexity 값이 낮을 거고, "좋다" 외에 다른 단어를 예측하는 데 어려움을 겪으면 Perplexity 값이 높을 거야.

2. Perplexity가 어떻게 계산되는가?

Perplexity는 모델이 예측한 확률을 기반으로 계산돼. 좀 더 구체적으로 보면:

- 단어의 확률 계산: 모델은 주어진 문맥을 바탕으로 다음에 올 단어가 무엇일지 확률을 계산해. 예를 들어, "오늘 날씨가"라는 부분이 있을 때, 모델은 다음에 "좋다", "맑다", "비가 온다" 등 다양한 단어들이 올 확률을 계산하겠지.

- 각 단어의 확률을 로그 변환: 각 단어에 대해 모델이 예측한 확률을 로그화해서 계산해. 이렇게 로그 변환을 하는 이유는 확률 값이 너무 작은 값이 될 수 있어서 이를 다루기 편하게 만들기 위해서야.

- Perplexity 값 계산: 결국, Perplexity는 그 로그 값들의 평균을 기반으로 계산한 후, 다시 지수화(exponential) 해서 나온 값이야. Perplexity 공식은 대체로 다음과 같아:PPL=2−1N∑i=1NlogP(wi∣w1,w2,…,wi−1)PPL = 2^{-\frac{1}{N} \sum_{i=1}^{N} \log P(w_i | w_1, w_2, \dots, w_{i-1})}여기서:

- P(wi∣w1,…,wi−1)P(w_i | w_1, \dots, w_{i-1})는 각 단어가 주어진 문맥에서 나올 확률,

- NN은 문장의 길이(단어 수),

- ∑\sum는 문장의 각 단어에 대해 계산한 로그 확률의 합.

3. Perplexity 값 해석

- Perplexity가 낮을수록 좋다: 모델이 예측한 확률이 실제 정답에 가까울수록 Perplexity 값이 낮다. 즉, 모델이 문맥을 잘 이해하고 있다는 뜻이야.

- Perplexity가 높을수록 나쁘다: 모델이 예측한 확률이 실제 정답과 많이 차이가 나면 Perplexity가 높다. 이는 모델이 문맥을 잘 못 이해하거나 예측을 잘 못 했다는 의미야.

4. Perplexity의 실제 예시

- 문장 1: "오늘 날씨가 정말 좋다."

- 모델이 이 문장에서 "오늘" 다음에 "날씨"가 올 확률, "날씨" 다음에 "가"가 올 확률, "가" 다음에 "정말"이 올 확률 등을 잘 예측할 수 있다면, Perplexity는 낮을 거야.

- 문장 2: "오늘 날씨가 비가 온다."

- "비가"는 날씨와 연결될 수 있지만, "온다"는 갑자기 변화가 있는 예측이라면, Perplexity는 좀 더 높을 수 있어. 모델이 "비가 온다"라는 패턴을 잘 예측하지 못했다면 말이지.

5. Perplexity의 한계

- Perplexity가 낮다고 항상 "좋은 모델"이라고 할 수는 없어. Perplexity는 단지 예측 정확도만 측정하는 지표일 뿐이니까. 실제로 모델이 특정한 문맥에서는 잘 예측을 해도, 다른 문맥에서는 잘못 예측할 수 있어.

- 문맥의 다양성: Perplexity가 낮은 모델이 항상 모든 종류의 문맥에서 잘 동작한다는 보장은 없어. 어떤 문맥에서는 Perplexity가 낮지만, 다른 문맥에서는 성능이 나쁠 수 있어.

6. Perplexity 활용 예시

- 언어 모델 비교: 여러 언어 모델을 비교할 때, Perplexity 값이 낮은 모델이 상대적으로 더 정확한 예측을 한다고 볼 수 있어.

- 모델 개선: Perplexity 값을 모니터링하면서 모델을 튜닝하거나 학습 데이터셋을 개선할 수 있어.

7. 실제 코드 예시 (간단한 예시)

import math

# 예시 확률 값 (단어별 확률)

probabilities = [0.2, 0.1, 0.3, 0.4]

# Perplexity 계산 함수

def calculate_perplexity(probabilities):

n = len(probabilities)

log_prob_sum = sum(math.log2(p) for p in probabilities)

return 2 ** (-log_prob_sum / n)

perplexity = calculate_perplexity(probabilities)

print(f"Perplexity: {perplexity}")

이 코드에서는 주어진 확률 값을 사용해서 Perplexity를 계산해. 확률 값이 다르면 Perplexity 값도 달라질 거야.

이 정도로 Perplexity에 대한 자세한 설명을 마쳤어! AI 모델을 평가할 때, Perplexity가 어떻게 활용되는지 이제 좀 더 명확하게 이해할 수 있겠지?

위와 같이 이런 저런 이야기로 설명하면 어렵겠지만 우리 아저씨 아줌마들은

아래 내용으로 요약할 수 있어 .

1. ChatGPT는 마치 '친절한 비서' 같아.

- 비유: ChatGPT는 마치 친절한 비서 같아. 너가 어떤 질문을 하면, 이 비서는 바로 답을 해줘. 예를 들어, "오늘 날씨 어때?"라고 물으면 날씨를 알려주고, "내일 무엇을 먹을까?"라고 물으면 식사 아이디어도 줄 수 있어.

- 실제 역할: ChatGPT는 대화를 통해 정보를 제공하거나, 도움을 주는 역할을 해. 사람처럼 대답하고, 대화가 자연스럽게 이어져.

2. Perplexity는 '시험 점수' 같아.

- 비유: Perplexity는 마치 시험 점수 같아. 예를 들어, 너가 수학 문제를 풀었을 때, 점수가 100점이면 그 문제를 잘 풀었다는 거고, 60점이면 조금 실수가 있었다는 거지. Perplexity도 AI가 예측하는 능력을 점수로 나타내는 거야. 점수가 낮으면 잘 예측했다는 뜻이고, 점수가 높으면 예측을 잘 못했다는 거야.

- 실제 역할: Perplexity는 AI가 얼마나 잘 예측하는지를 평가하는 수치야. AI가 문제를 잘 풀었는지 확인하는 방식이지.

실생활에서 차이를 비유로 정리하면 이렇게 될 거야:

ChatGPT (친절한 비서) Perplexity (시험 점수)

| 너가 무엇을 물어보면 친절하게 답을 준다. | AI가 얼마나 잘 예측하는지 시험 점수처럼 평가한다. |

| 예: "오늘 저녁에 뭐 먹을까?"라고 물으면, 식사 추천을 해준다. | 예: AI가 "오늘 날씨는" 다음에 "좋다"나 "맑다"를 예측하는 능력을 평가한다. |

| 대화하면서 도움을 주는 역할. | AI의 성능이 얼마나 좋은지 점수로 평가하는 역할. |

결론:

- ChatGPT는 친구 같은 비서로, 대화하면서 우리가 궁금한 것에 답해준다.

- Perplexity는 AI의 시험 점수처럼, AI가 얼마나 정확하게 예측하는지를 숫자로 평가하는 거야.

이렇게 비유하면 좀 더 쉽게 이해할 수 있을 거야!

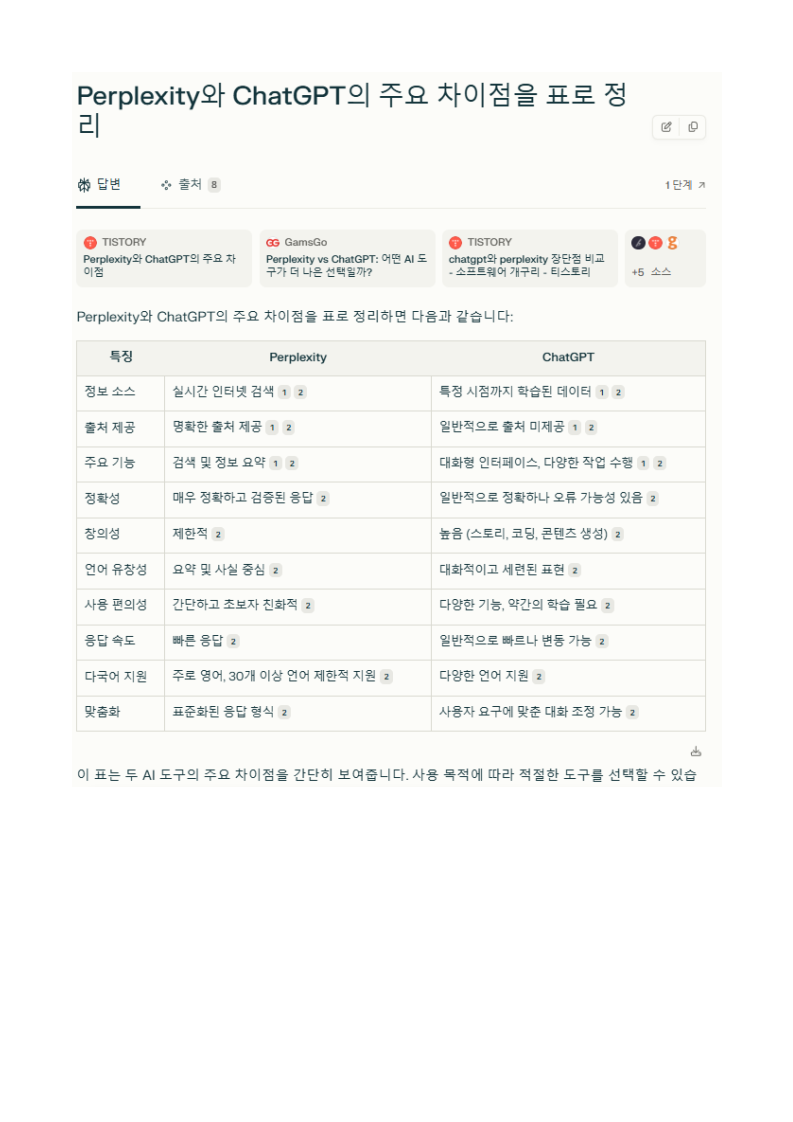

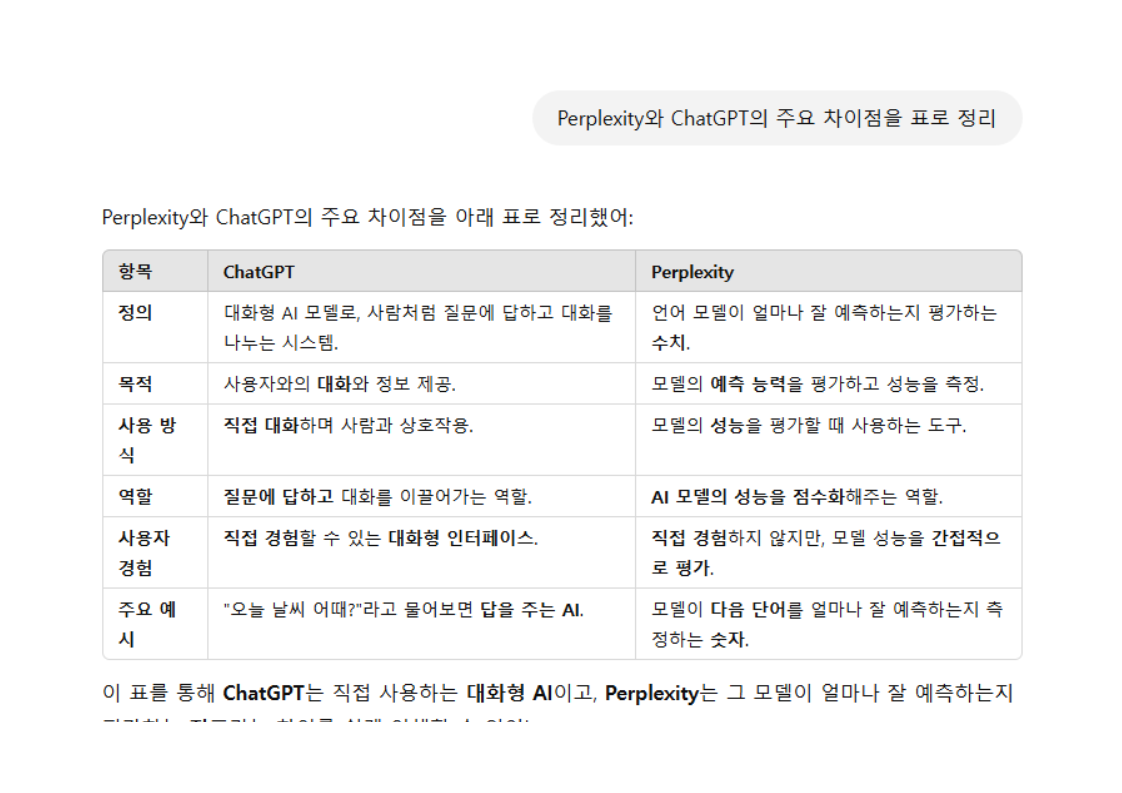

Perplexity와 ChatGPT의 주요 차이점을 표로 정리

같은 질문을 했을때 차이를 보면 이해를 좀 하겠지

1. 펄플렉시티에게 질문

2. 챗 지피티에게 똑같은 질문 했을때

| 정보 소스 | 실시간 인터넷 검색 | 특정 시점까지 학습된 데이터 |

| 출처 제공 | 명확한 출처 제공 | 일반적으로 출처 미제공 |

| 주요 기능 | 검색 및 정보 요약 | 대화형 인터페이스 |

| 사용 목적 | 정보 검색, 연구, 요약 | 다목적 대화, 창작 |

| 최신 정보 | 실시간 업데이트 | 제한적 |

| 이미지 검색 | 가능 | 현재는 불가능 |

| 정확성 | 높은 정확성 (출처 기반) | 때로 부정확할 수 있음 |

| 특화 분야 | 연구, 학술적 목적 | 일반 대화, 창의적 작업 |

'AI와 아저씨 아줌마들' 카테고리의 다른 글

| AI-4편 : Notion AI : 아저씨 아줌마들의 메모 비서!!! (0) | 2025.03.30 |

|---|---|

| AI-3편 : 릴리스 AI : 아저씨 아줌마들을 위한 AI 요약 도구! (1) | 2025.03.29 |

| AI-1편 : 아저씨 아줌마들아 ChatGPT 이렇게 쓰면 진짜 편해 (2) | 2025.03.27 |

| AI 시리즈 : 아저씨 아줌마들아 이 건 꼭 알자!!!! AI 9가지 (0) | 2025.03.26 |

| 쿠팡 파트너스: 제휴 마케팅을 통한 수익화 전략 (3) | 2025.03.25 |